Ihre Metriken lügen: Wie Sie die Auswirkungen des Bot-Verkehrs auf Ihre Daten in den Griff bekommen

Laut dem "Radar Report" von Cloudflare werden schätzungsweise 40 % des gesamten Internetverkehrs von Bots erzeugt Für diejenigen unter uns, die im Marketing und in der Datenanalyse tätig sind, ist das eine große Sache - Bots können unsere Berichte verfälschen und dazu führen, dass wir uns auf ungenaue Metriken verlassen, oft ohne dass wir es überhaupt wissen. Bei Daten ist es schon schwierig genug, sicherzustellen, dass alles ordnungsgemäß erfasst wird; aber wie kann man bei Traffic-Bots echte Erkenntnisse gewinnen?

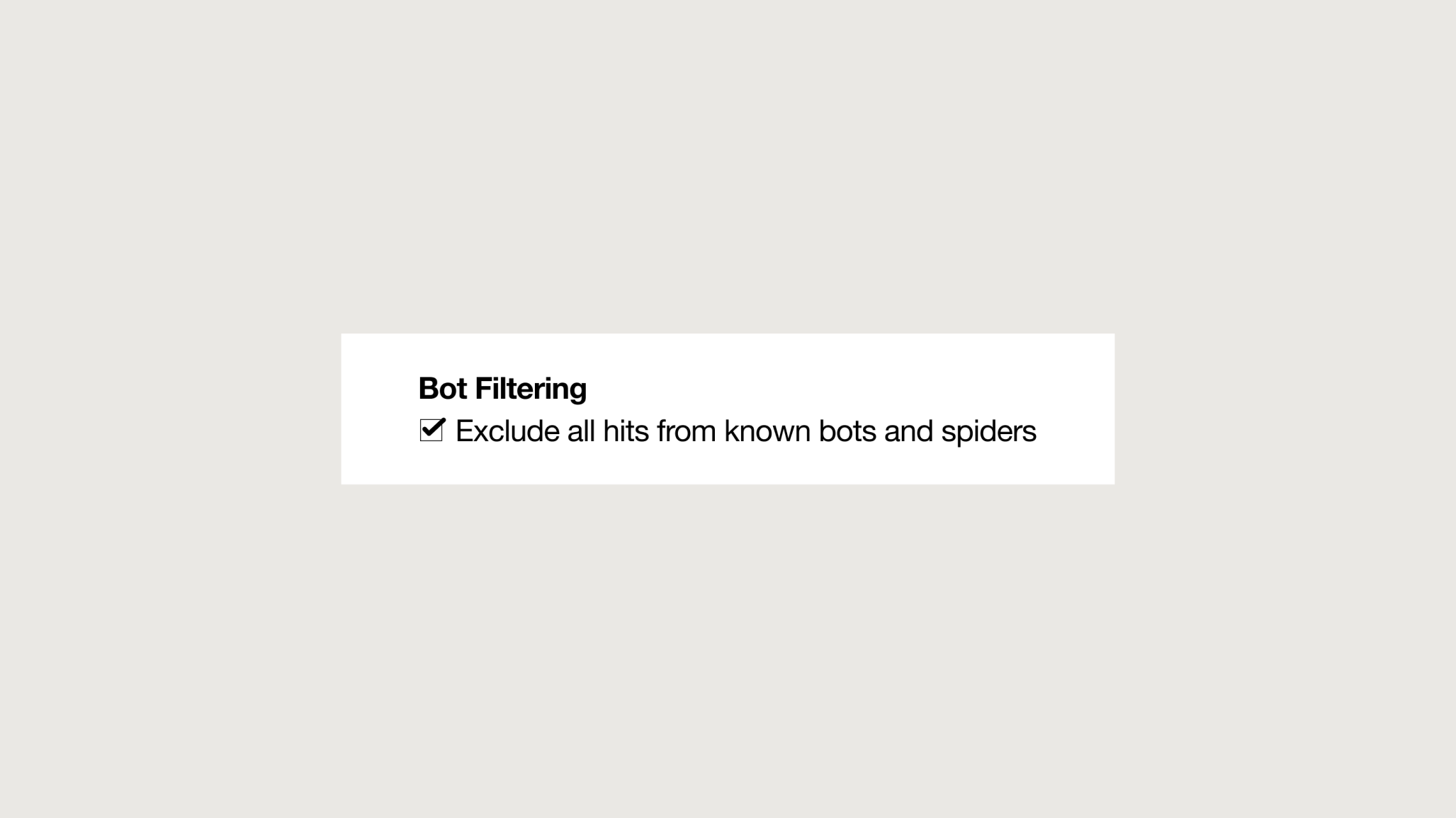

Als Reaktion auf dieses Problem haben die beliebtesten digitalen Analysetools begonnen, Bot-Filterfunktionen anzubieten. Es ist zwar ratsam, sie zu aktivieren, aber sie haben sich als sehr wenig wirksam gegen die verschiedenen Arten von Bots erwiesen, die es im Web gibt. Schlimmer noch, sie könnten echten und nützlichen Bot-Verkehr herausfiltern und so die Daten zugunsten von ungenauem Verkehr verzerren.

Unterm Strich sind unsere Daten in Gefahr.

Welche Auswirkungen hat Bot-Traffic auf Ihr Unternehmen?

Für Unternehmen, die Geschäftsentscheidungen auf der Grundlage von Daten treffen, kann Bot-Traffic nachteilige Folgen für ihre digitalen Strategien haben. Er verzerrt verschiedene Metriken wie Konversionsraten, Absprungraten, Gesamtnutzer und Sitzungen und führt zu unerklärlichen Schwankungen. Außerdem kann erhöhter Traffic die Kosten für digitale Analysetools in die Höhe treiben, da viele Preismodelle auf der Anzahl der Besuche basieren. KI-Tools und -Implementierungen, die auf Daten trainieren, die von Traffic-Bots beeinflusst werden, können ungenaue Erkenntnisse liefern. Bot-Verkehr kann auch Websites durch Überlastung der Server lahmlegen, was zu langsamen Seitenladezeiten führt oder in schweren Fällen die Website für die Nutzer unzugänglich macht. Im Extremfall kann die Zulassung von unerwünschtem Datenverkehr zu Sicherheitslücken und zum Abfluss sensibler Informationen führen.

Kürzlich bat uns einer unserer Kunden um Unterstützung bei der Überprüfung eines plötzlichen Anstiegs des Datenverkehrs aus Frankfurt in den frühen Morgenstunden, der nicht mit seinen historischen Daten übereinstimmte. Nach der Analyse der Berichte und dem Abgleich der verschiedenen verfügbaren Dimensionen stellten wir fest, dass in bestimmten Zeiträumen 90 % der in den Berichten erfassten Gesamtnutzer ein Verhalten an den Tag legten, das sich nur schwer auf Menschen zurückführen ließ. Dies beeinträchtigte nicht nur die Datenqualität ernsthaft, sondern verursachte auch erhebliche Kosten aufgrund des Besuchervolumens auf der Website.

Doch nicht nur Extremsituationen können unsere Datenqualität beeinträchtigen. Selbst ein kleiner Prozentsatz von Anomalien kann zu unzuverlässigen Berichten führen. Wie können wir dies also verhindern und unsere Daten zuverlässig halten?

Den Feind kennen

Der erste Schritt zur wirksamen Bekämpfung von Bots besteht darin, sie zu verstehen. Nicht alle Bots sind gleich; jeder Typ erfordert eine eigene Strategie. Eine gängige Klassifizierung unterscheidet zwischen bösartigen und nicht-bösartigen Bots. Schauen wir uns einige typische Beispiele für bösartige Bots an.

Arten von bösartigen Traffic-Bots

1. Scalper-Bots:

Diese Programme schnappen sich blitzschnell Tickets und andere begrenzt verfügbare Waren, um sie später zu höheren Preisen weiterzuverkaufen.

2. Spam-Bots:

Sie überschwemmen Ihren Posteingang oder Ihre Nachrichten mit Junk-Mails, die oft mit bösartigen Links versehen sind. Wer hat nicht schon einmal eine lästige Spam-Mail erhalten?

3. Scraper-Bots:

Diese Bots extrahieren automatisch Daten von Websites und kopieren oft Inhalte von Konkurrenten, um sich einen Vorteil zu verschaffen.

Nicht bösartige Bots hingegen sind diejenigen, die mühsame Aufgaben schnell erledigen können. Sie sammeln große Datenmengen, deren Abruf sonst Tage oder sogar Monate dauern würde, und entlasten den Menschen bei sich wiederholenden Aufgaben.

Arten von nützlichen Traffic-Bots

1. Spider (Webcrawler):

Die Bots von Google gehören zu den fortschrittlichsten. Sie durchsuchen das Internet unermüdlich nach Videos, Bildern, Texten, Links und vielem mehr. Ohne diese Crawler würden Websites keinen organischen Suchverkehr erhalten.

2. Backlink-Prüfer:

Diese Tools helfen Ihnen, alle Links zu finden, die eine Website oder Seite von anderen Websites erhält. Sie sind für die Suchmaschinenoptimierung von entscheidender Bedeutung.

3. Website-Überwachungs-Bots:

Diese Bots überwachen Websites und können den Besitzer alarmieren, wenn die Website beispielsweise von Hackern angegriffen wird oder offline geht.

Mein Ziel ist es nicht, alle Arten von Bots ausführlich zu beschreiben, da sie sich ständig weiterentwickeln. Stattdessen möchte ich die verschiedenen Verhaltensweisen aufzeigen, die unsere Filter- und Entfernungsstrategien beeinflussen, sowie die damit verbundene Komplexität. Letztendlich sind alle Bots, ob sie nun gut oder schlecht sind, in unseren Berichten unerwünscht, und wir müssen ihre Auswirkungen auf unsere Daten minimieren.

Bot-Angriffe mit den richtigen Tools abwehren

Heutzutage gibt es sowohl automatisierte als auch manuelle Strategien, um diese Herausforderung zu bewältigen. Bei den automatisierten Lösungen stechen Bot-Filterprogramme hervor, die entweder in Analysetools integriert sind oder spezielle Software zur KI-gesteuerten Bot-Erkennung. Wie bereits erwähnt, ist ihre Effektivität jedoch eher gering, und in vielen Fällen sind sie mit Kosten verbunden.

Auf der anderen Seite gibt es nicht-automatisierte Lösungen, die bessere Ergebnisse liefern, und wir können sie auf der Grundlage ihres Filteransatzes kategorisieren:

Reaktiver Ansatz: Anwendung benutzerdefinierter Filter auf Berichtsebene. Diese Methode ist einfach und flexibel und erfordert keine Änderungen auf Entwicklungsebene. Sie ist ein effektiver erster Schritt zur Früherkennung. Die Verwendung von Tools, die in Analyseplattformen verfügbar sind - wie GA4-Segmente, Looker Studio-Filter und Data-Warehouse-Abfragen - macht die Implementierung einfach, obwohl sie weniger robust ist.

Vorbeugender Ansatz: Implementieren Sie Filter vor der Datenerfassung. Dies kann zwar schwierig und ressourcenintensiv sein, verhindert aber effektiv die Auswirkungen auf die Berichterstattung und schränkt den Zugriff von Bots auf die Website und ihre Server ein.

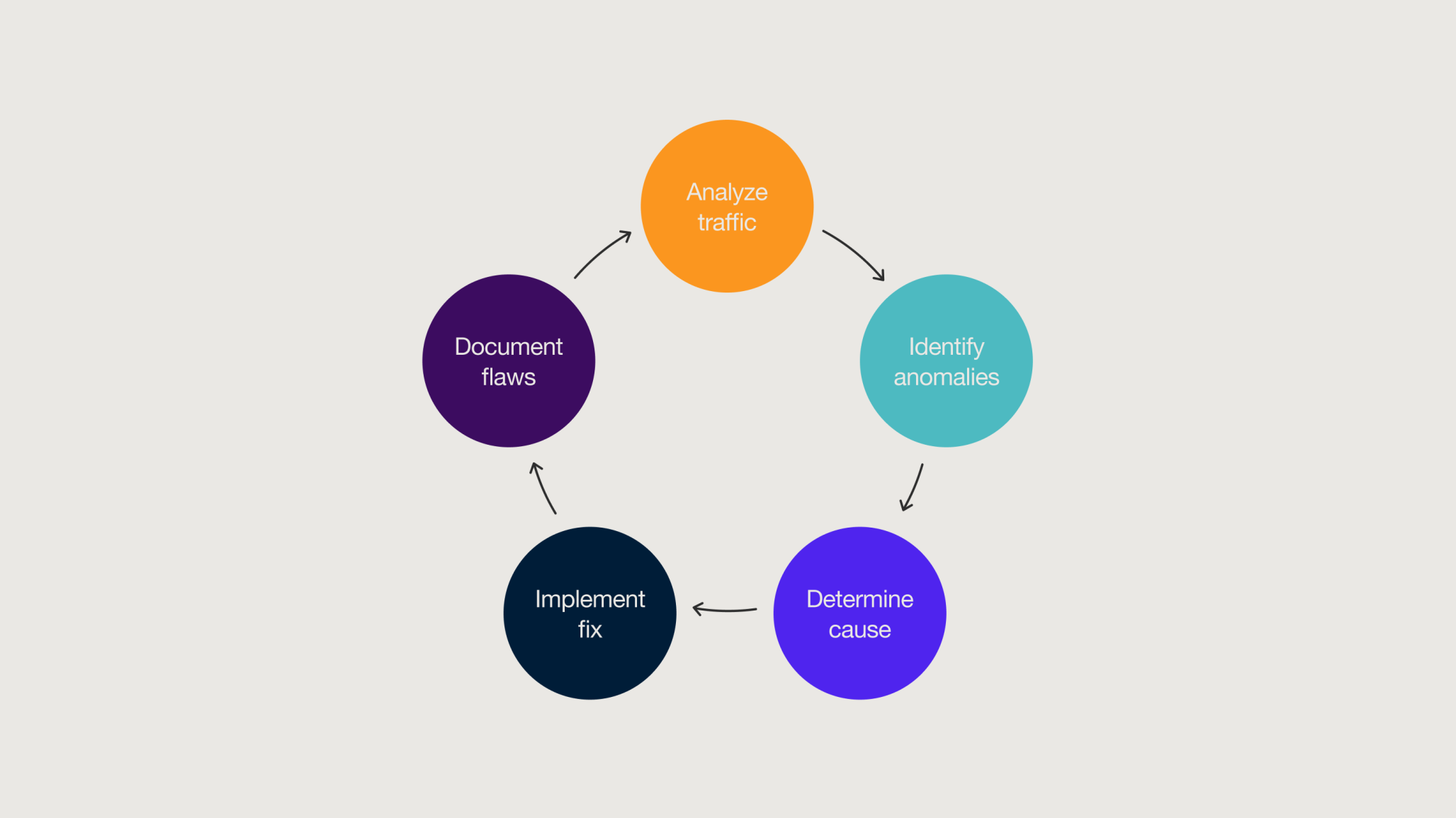

Einrichtung eines Zyklus zur Überprüfung der Datenqualität

Um unsere Daten frei von Bot-Verkehr zu halten und optimale Ergebnisse zu gewährleisten, ist es am besten, eine umfassende Strategie anzuwenden, die sowohl präventive als auch reaktive Maßnahmen kombiniert. Dies ist der so genannte Datenqualitätsprüfungszyklus, ein Modell der kontinuierlichen Überwachung, das auf die ständige Erkennung von Anomalien ausgerichtet ist. Dabei arbeiten Analysten, Entwickler und Produktverantwortliche zusammen, um effiziente Lösungen zu finden, die die Integrität und Zuverlässigkeit der Daten gewährleisten.

Auch wenn wir den Bot-Verkehr nicht völlig aus unseren Berichten verbannen können, bietet uns die proaktive Umsetzung von Strategien zur Überprüfung der Datenqualität praktische und effektive Möglichkeiten, dieses Problem anzugehen.

Zusammengefasst

- Bots können sowohl schädlichen als auch nützlichen Zwecken dienen; in beiden Fällen ist es wichtig, sie aus den Berichten herauszuhalten.

- Bot-Traffic hat negative Folgen für digitale und kommerzielle Strategien.

- Zwar verfügen Analyseplattformen über Funktionen, die einen Teil des Bot-Verkehrs automatisch blockieren, doch ihre Wirksamkeit ist begrenzt.

- Die ständige Überwachung von Anomalien in den Berichten ist für die Identifizierung von Bot-Traffic unerlässlich.

- Um eine unerwünschte Beeinflussung des Datenverkehrs zu vermeiden und sicherzustellen, dass die Daten nicht verzerrt oder kontaminiert sind, müssen sowohl präventive als auch reaktive Maßnahmen ergriffen werden.

- Die Aufnahme eines Zyklus zur Überprüfung der Datenqualität in den Arbeitsablauf ist entscheidend dafür, dass die Berichte frei von Bot-Traffic bleiben.

Verwandte

Themen

-

![Monks and Hightouch partner on CDP and AI]()

Blog-Beitrag

Monks und Hightouch schmieden eine neue Partnerschaft für datengesteuertes Marketing und KI in APAC Von Peter Luu 3 min Lesezeit -

![A vibrant, flowing wave of translucent material reflecting colorful lights in shades of pink, blue, and purple. The background features a soft bokeh effect with blurred light sources, enhancing the ethereal and dynamic feel of the scene.]()

Blog-Beitrag

Smarteres Marketing mit Salesforce Marketing Intelligence Von Ashley Musumeci 4 min Lesezeit -

![Man using an electric sander]()

Blog-Beitrag

Häufige Hindernisse bei der Einführung Ihres Marketing Mix Modelling (MMM) Programms Von Tim Fisher 3 min Lesezeit

Schärfen Sie Ihre Kanten in einer Welt, die nicht warten will

Melden Sie sich an, um E-Mail-Updates mit umsetzbaren Erkenntnissen, aktuellen Forschungsergebnissen und bewährten Strategien zu erhalten.

Monks benötigt die Kontaktinformationen, die Sie uns zur Verfügung stellen, um Sie über unsere Produkte und Dienstleistungen zu informieren. Sie können sich jederzeit von diesen Mitteilungen abmelden. Informationen darüber, wie Sie sich abmelden können, sowie über unsere Datenschutzpraktiken und unsere Verpflichtung zum Schutz Ihrer Daten finden Sie in unserer Datenschutzrichtlinie.